How ChatLab Leverages RAG Technology?

April 18th, 2025 by Bartek Mularz

How ChatLab Leverages RAG Technology?

At ChatLab, we create intelligent chatbots that revolutionize online interactions. The key driver behind their capabilities is an innovative technology called Retrieval-Augmented Generation (RAG). This forms the foundation of our system, enabling us to deliver solutions that go beyond standard conversations.

In the world of chatbots, there are two main training methods. The first involves intensive training of complex neural networks—a process that is intricate, time-consuming, and costly. The second approach, which we successfully employ at ChatLab, is RAG. Not only is it simpler, more cost-effective, and faster to implement, but it also grants our chatbots access to unlimited external sources of information—such as your own files. This allows us to generate responses that are highly precise, context-aware, and personalized.

We invite you to read on and delve deeper into how RAG technology powers ChatLab!

What exactly is RAG?

To understand how our system works, it’s worth taking a closer look at Retrieval-Augmented Generation. While interacting with a chatbot may seem intuitive from a user’s perspective, grasping the mechanisms behind its operation allows you to fully appreciate its potential.

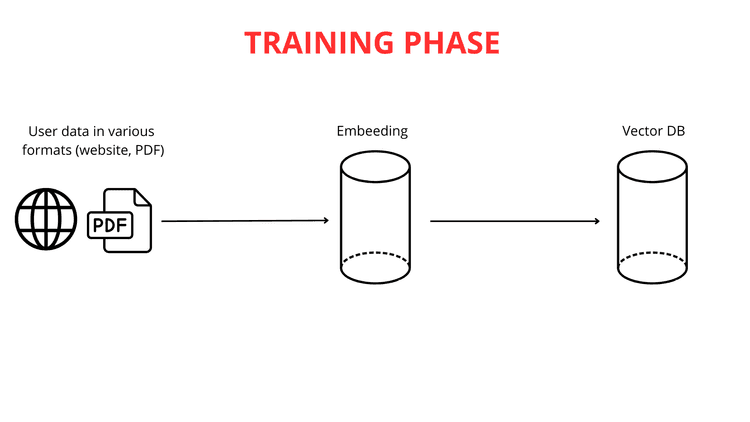

Building an intelligent chatbot is a process rooted in knowledge from multiple scientific disciplines. The first and most crucial step is feeding the chatbot data. At ChatLab, we enable this in several convenient ways: by uploading website content, extensive documentation, or even your own PDF files. The possibilities for customizing the knowledge base to your needs are virtually limitless.

The next stage involves breaking down long texts into smaller chunks (up to 600 tokens each), making it easier for the system to process information efficiently. Once the data is uploaded and segmented, the vector mapping process begins.

It’s important to emphasize that text-to-vector mapping is critical to RAG’s functionality. Powerful large language model (LLM) engines are responsible for generating these vector representations.

The Role of Vector Mapping in Text Understanding

Text vectorization is essentially converting words into lists of numbers—constructed in such a way that words with similar meanings receive similar numerical representations (vectors). This allows our chatbot to "understand" relationships between different word sequences. For example, the words "big" and "huge" would be transformed into very similar numerical lists, while "big" and "ant" would receive entirely different representations.

By analyzing these numerical similarities and differences, the chatbot can infer that "cat" and "dog" are more closely related than "cat" and "green."

Once vectors are generated, these numerical representations of knowledge are stored in a vector database alongside the original content. The vector database acts as an advanced catalog of vectorized knowledge, optimized for rapid retrieval of related meanings.

The Vector Database: An Intelligent Knowledge Library

To better understand how a vector database works, let’s use the analogy of a library with a smart search system. Each "book" (text fragment) is "tagged" by a unique vector (a sequence of numbers). This code contains multiple numbers representing the author, style, and subject matter of the book. Two books on similar topics will have very similar codes.

In this "library," books are placed on "shelves" in a multi-dimensional space based on their codes. Books with similar codes are grouped close together—much like books in the same category but further organized by subtle content similarities. When you ask a question (e.g., "What’s the recipe for chocolate cake?"), it is converted into such a "code." The smart search system in the vector database scans the "shelves" (text fragments) for codes most closely matching your query’s code.

The algorithm quickly identifies the "books" (fragments) most likely to contain the answer. Instead of searching the entire "library," the chatbot instantly pinpoints the most relevant pieces of knowledge in terms of meaning. This ensures faster, more accurate, and context-focused responses.

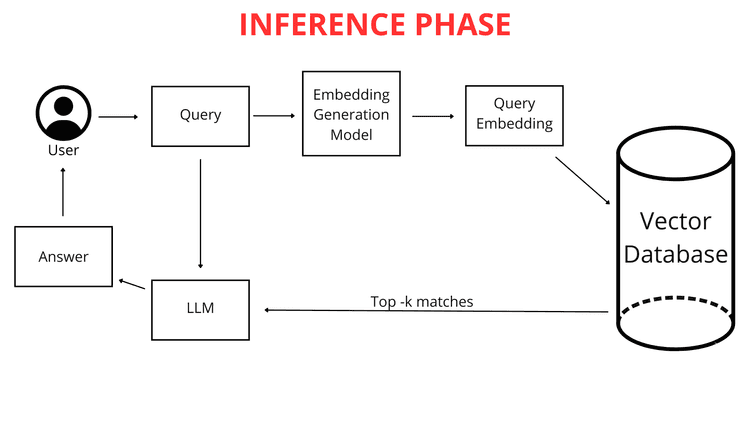

What Happens When You Ask a Question?

When you, as a user, type a question into the chatbot (e.g., "What’s the weather in Krakow tomorrow?"), it isn’t immediately compared to the chatbot’s knowledge in raw text form. First, the question is mapped into a numerical vector. Because both your question and the chatbot’s entire knowledge base are represented in the same format—as vector maps (lists of numbers)—the chatbot can efficiently compare them. It identifies the fragments of its knowledge most closely related to your query’s vector, enabling it to generate the best possible answer.

RAG Springs Into Action

This is where RAG technology plays a pivotal role. The RAG system analyzes the vector representation of your query and uses it to search the vector database for the numerical lists most similar to it (closest in the multi-dimensional space). These most similar vectors point to the original file fragments most relevant to your question.

RAG acts like an intelligent "bridge" between your query and the chatbot’s vast knowledge base. It enables dynamic retrieval of only the information most needed for the LLM (Large Language Model) to formulate a response. An LLM, in simple terms, is an advanced algorithm and dataset trained on massive amounts of text, capable of understanding and generating natural language. LLMs can answer questions and even create diverse content.

Without RAG, an LLM would have to rely solely on its built-in knowledge, which might not include specific details from your files or could be outdated. Thanks to RAG, the chatbot gains the ability to tap into additional external knowledge precisely when you ask a question. This fresh knowledge comes directly from your uploaded files and web pages, which have been properly processed.

The Difference Between a Chatbot With and Without RAG

The key difference is in how knowledge is accessed.

Trained Knowledge (Without RAG): This is the LLM’s "built-in" knowledge, acquired during intensive training on vast datasets before your interaction with ChatLab. If you ask about something not covered in that data, the model may simply not know the answer.

Your Files’ Knowledge (Used via RAG): This is your unique, specialized knowledge that you provide to the chatbot. RAG allows the chatbot to dynamically access this knowledge when answering questions, combining it with its general training knowledge to generate a comprehensive response.

An Analogy:

Imagine an LLM as an extremely intelligent student who has read countless books (training data) and possesses impressive general knowledge. Now, you provide them with your lecture notes and handouts (your files). RAG acts as a system that lets this student quickly check your notes when answering a question, rather than relying solely on what they remember from all those books. This enhancement guarantees better, more precise, and—most importantly—more up-to-date answers.

Thanks to RAG, the chatbot can expand its knowledge with your unique data and actively use it in interactions. It isn’t limited only to what it learned during its initial training.

This is why RAG is invaluable when you need a chatbot to answer questions about your specific information—details that aren’t publicly available or are too niche to be included in general LLM training data.

If your question is: "Where can I find books about space?", before the "librarian" (chatbot) starts "searching the shelves," it first "translates" your question into the "language of the shelves"—identifying the appropriate book category. Creating a vector map of your question is like cataloging your query into categories the chatbot understands and can access via the vector database.

The Training and Knowledge Utilization Phase

As explained earlier, your question is converted into a list of numbers representing its meaning. The chatbot then searches the vector database for the most similar vectors representing knowledge fragments. The closer the vector representations, the greater the similarity between your question and those knowledge fragments.

The chatbot selects the most closely matching fragments of its pre-processed knowledge—those whose vectors are nearest to your question’s vector map. Importantly, when analyzing your query, ChatLab considers not just the question itself but also the context of the entire conversation so far. This allows the RAG system to more precisely select the best information from connected knowledge sources.

For example, if you first ask about "the latest phone models" and then follow up with "Do they have good cameras?", the chatbot—remembering the conversation context—understands that you’re still referring to those specific phones.

The selected knowledge fragments are combined with your original question and instructions from the "Role & Behavior" section. These instructions, also known as the prompt, are our personalized set of guidelines for the chatbot. If we want the chatbot to always add a source link at the end of its response or greet users in a specific way, we include this in the prompt.

This creates an augmented query, which is then passed to the chatbot’s "brain"—the large language model (LLM) from OpenAI, Google, or other providers.

The language model analyzes this complex set of information: the prompt, the conversation history, and the knowledge retrieved for the user’s query. Additionally, the LLM leverages its general world knowledge to generate a response. Finally, the refined and polished answer is presented in ChatLab’s clean interface.

Summary

In this article, we’ve walked through the architecture of the RAG system in chatbot functionality—from data input to response generation. RAG is a fundamental component of modern conversational systems, enabling efficient use of external knowledge. Companies like ChatLab actively integrate this groundbreaking technology into their products, delivering advanced and intelligent interaction capabilities to clients.

While the RAG system has some technical complexity, its impact on AI-generated text is undeniable. The fact that it’s successfully used by leading tech companies like Google, Microsoft, and Amazon underscores its pivotal role in the dynamic evolution of artificial intelligence.